随着人工智能的发展,越来越多的研究者和企业希望构建自己的大模型服务器。本文将为您详细介绍自建大模型服务器的步骤,确保您能够顺利进行搭建和优化,以满足专业的需求。

一、明确构建目标和需求

在开始之前,首先需要明确您建立大模型服务器的目的。不同的应用场景可能对硬件配置、软件环境、网络连接等有着不同的要求。确定这些目标将指导您在接下来的构建过程中做出更合理的选择。

二、硬件准备

构建大模型服务器对硬件的要求较高,以下是关键的硬件部件及其选择要点:

1.主机选择

选择性能强大的服务器,多核CPU、大容量内存(建议至少128GB)是基础,还需要足够大的存储空间来存储模型数据和训练过程中的临时数据。

2.显卡

为了满足大规模深度学习计算的需求,高性能的GPU显卡是必不可少的。建议选择具备TensorCore技术的NVIDIA显卡,并根据模型大小和计算需求合理配置显卡数量。

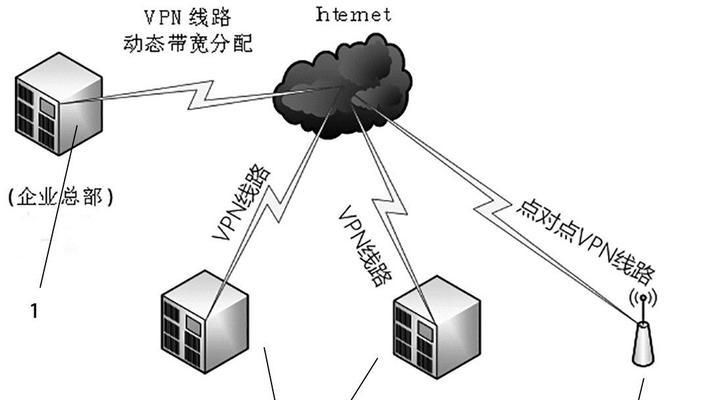

3.网络设备

大模型训练往往需要高速网络支持,因此选择支持高带宽和低延迟的网络设备至关重要。

三、系统环境搭建

1.操作系统

安装稳定的操作系统版本,如UbuntuServer,确保能够得到最新的系统安全更新和驱动支持。

2.驱动安装

安装GPU驱动和CUDA、cuDNN等深度学习框架所需的基础软件包。

3.深度学习框架

选择并安装适合大模型训练的深度学习框架,如TensorFlow或PyTorch,并安装相应的依赖库。

四、环境配置与测试

1.Python环境

搭建Python虚拟环境,并安装必要的Python包和库。

2.网络配置

设置网络环境,确保服务器可以稳定连接至网络,并配置好防火墙和端口。

3.性能测试

进行初步的性能测试,检查硬件是否满足预期的计算需求。

五、大模型部署

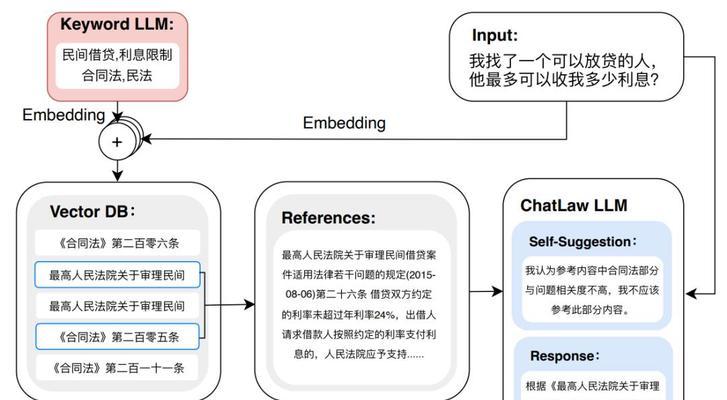

1.模型获取

您可以从开源社区获取现有模型,或者根据需要自行设计模型架构。

2.模型训练

使用提供的数据集开始模型训练工作,并监控训练进度和资源使用情况。

3.调优优化

根据训练过程中的反馈对模型参数进行调整,以达到更好的训练效果。

六、维护与升级

1.定期检查

定期对服务器硬件进行检查和维护,确保其稳定运行。

2.软件更新

更新系统和框架的版本,以获取最新的性能改进和安全补丁。

3.系统备份

定期备份系统和数据,以防数据丢失或系统故障。

结语

通过以上六个步骤,您可以顺利完成自建大模型服务器的过程。请记住,搭建服务器只是第一步,如何持续优化性能、管理数据和确保系统的安全稳定运行也同等重要。我们希望本文能够为您提供一个清晰的指导路线图,帮助您更高效地达到目标。

在自建大模型服务器的过程中,您可能会遇到各种技术和非技术的挑战。若有更多疑问或需要进一步的技术支持,请随时与我们的专业团队联系。我们期待着与您共同探索人工智能的无限可能。